引 言

跨语言情感分析(Cross Lingual Sentiment Analysis, CLSA)旨在借助某一种/多种源语言(一般为情感资源丰富的语种,如英语),帮助另一种语言(目标语言,一般为情感资源匮乏的语种)开展情感分析工作。CLSA隶属于情感分析(Sentiment Analysis)领域,通过挖掘文本中的主观信息来判断其情感倾向。与单语下的情感分析研究相比,跨语言情感分析需要重点解决不同语言间的语法、语用等差异,搭建不同语言之间的知识关联以实现不同语言间的资源共享,使得在英语语言下的情感分析成果能够用于其他语种的情感分析研究,从而解决大部分非英语语言所面临的情感资源匮乏问题。

根据Ethnologue数据库统计分析,全球现有7139种语言,现有的情感分析研究大多在少数几种语言、尤其主要在英语语言下开展:积累了丰富的英文情感资源,如标注文本、情感词典等;而在其他语言中情感分析研究较少、情感语料资源较为匮乏。如果针对每一个语言进行情感数据的标注,则将耗费大量的人力物力。因此,跨语言情感分析提供了一种有效的解决方法。在经济全球化背景下,跨语言情感分析的意义日益凸显,逐渐成为情感分析领域的重要方向之一。

CLSA最早可追溯到2004年Yan等人[1]首次探索性地通过机器翻译(Machine Translation)来解决跨语言情感分析问题。诸多研究表明,CLSA能够将英语语言下积累的研究成果在其他语言情境下推广应用。例如,万小军等人[2]利用英语标注的情感分类数据,通过机器翻译实现对中文文本的情感分类预测。Vulic等人[3]通过跨语言词向量实现英语和荷兰语的相互检索。

CLSA在一些目标语言上的性能接近于单语语言下的情感分析性能,但仍有一些问题尚未解决。例如,基于机器翻译的跨语言情感分析方法仍难以避免词汇覆盖(Vocabulary Coverage)问题,即由于不同语言之间的语义表达和书写风格使得从单一源语言翻译的文本不能覆盖目标语言的所有词汇。此外,基于双语词嵌入的跨语言情感分析方法无法很好地解决语言对之间的语义差异(Semantic Difference)问题,即两种语言的语义差异较大、使得互为翻译的两个单词的词嵌入表示向量差距较大,得到双语词嵌入向量的生成质量不高。

本文整理和回顾了2004年至今、尤其是近十年间跨语言情感分析的文献。本文以Web of Science数据库为检索平台,构造检索式TS=cross lingual sentiment OR cross lingual word embedding,筛选过滤后选择相关性较高的文献656篇。以上述检索得到的文献为研究基础,延伸阅读相关文献后最终选取95篇作为参考文献。以这些参考文献为基础,按照CLSA的研究脉络以及CLSA采用的模型方法进行分类,并对各模型的原理、代表性研究、采用的实验数据集等进行总结和比较。

具体而言,CLSA的研究发展与机器学习、神经网络模型的发展密不可分,从总的研究脉络上可分为两个阶段:一个是早期的跨语言情感分析研究阶段,主要包括基于机器翻译及其改进的方法、基于平行语料库(Parallel Corpora)的方法和基于双语情感词典的方法;自2013年Mikolov等人[4]提出分布式词向量表示模型Word2vec,以及随着机器学习算法和神经网络模型的快速发展,跨语言情感分析进入了新的研究阶段,不仅仅停留在对基于机器翻译或基于平行语料库等有监督(Supervised)方法的改进,而是从有监督的跨语言情感分析方法逐渐发展到弱监督(Weakly-Supervised)、完全无监督(Fully-Unsupervised)的跨语言情感分析。本文的贡献如下:

(1)系统地总结了跨语言情感分析的研究方法,按照研究方法和技术进行细分归类,总结CLSA研究的主要思路、方法模型以及不足之处等。

(2)概述了现有跨语言情感分析覆盖的语言、数据集及其性能评价。不同语言对之间的语义距离不同,使得不同语言对的CLSA性能差别很大,即存在语言敏感性(Language-sensitive)问题。现有跨语言情感分析的性能验证大多在少数几个语种开展,一定程度上限制了跨语言情感模型的应用推广。例如,主要以英语为源语言,以法语、德语、日语、中文、西班牙语为目标语言。近年来也有将阿拉伯语、斯洛文尼亚语等小语种作为目标语言进行测试。本文通过对现有跨语言情感分析覆盖的语言、数据集及其评价性能进行总结分析,为语言无关的跨语言情感模型的研究提供一定的思路借鉴。

(3)总结归纳上述两点的分析结论,概述跨语言情感分析研究中面临的重要挑战、重要问题,并提出有待探索的研究方向。

1

早期的跨语言情感分析研究

1.1 基于机器翻译及其改进的方法

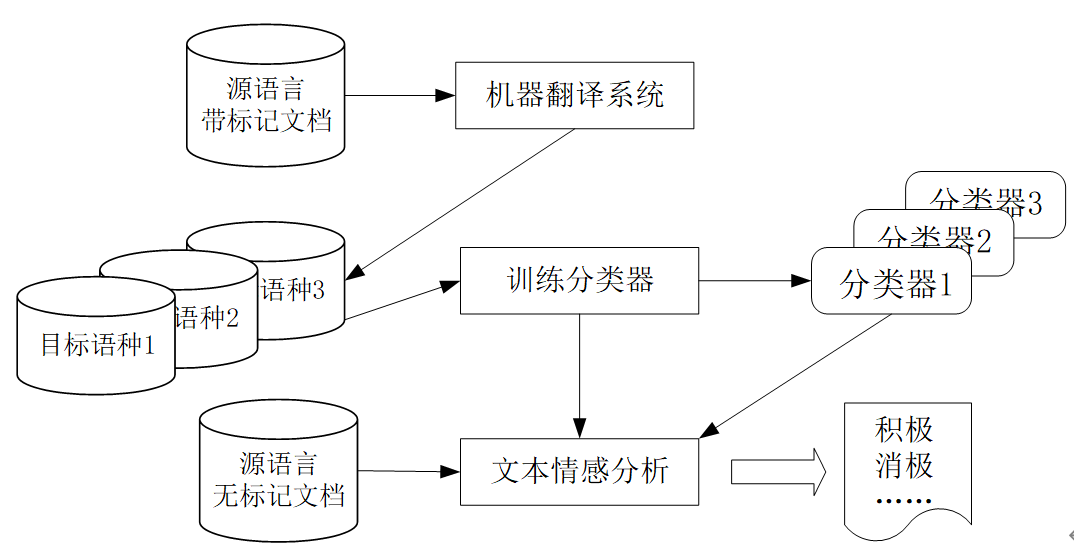

图1 基于机器翻译的跨语言情感分析方法示意图(引自[1])

Fig. 1 Structure of Cross-lingual Sentiment Analysis based on Machine Translation

2004年Yan等人[1]首次探索性地通过机器翻译解决跨语言情感分析问题。在随后近十年间,机器翻译一直是跨语言文本情感分析的主要方法,其基本思想是使用机器翻译系统将文本从一种语言翻译到另一种语言[5][6][7][8][9],从而实现多语言文本到单一语言文本的转换。如图1所示,将源语言的带标注数据翻译成目标语言[10][11],利用这些翻译后的数据训练情感分类器,实现对目标语言未标记数据的预测。也有一些研究将目标语言的未标注数据翻译成源语言,在源语言中进行情感分类预测[12][13][14]。此外,一部分研究兼顾上述两种翻译方向,创建从源语言到目标语言、以及目标语言到源语言两种不同的视图,以弥补一些翻译局限(Translation Limitations)[15][16][17][18]。

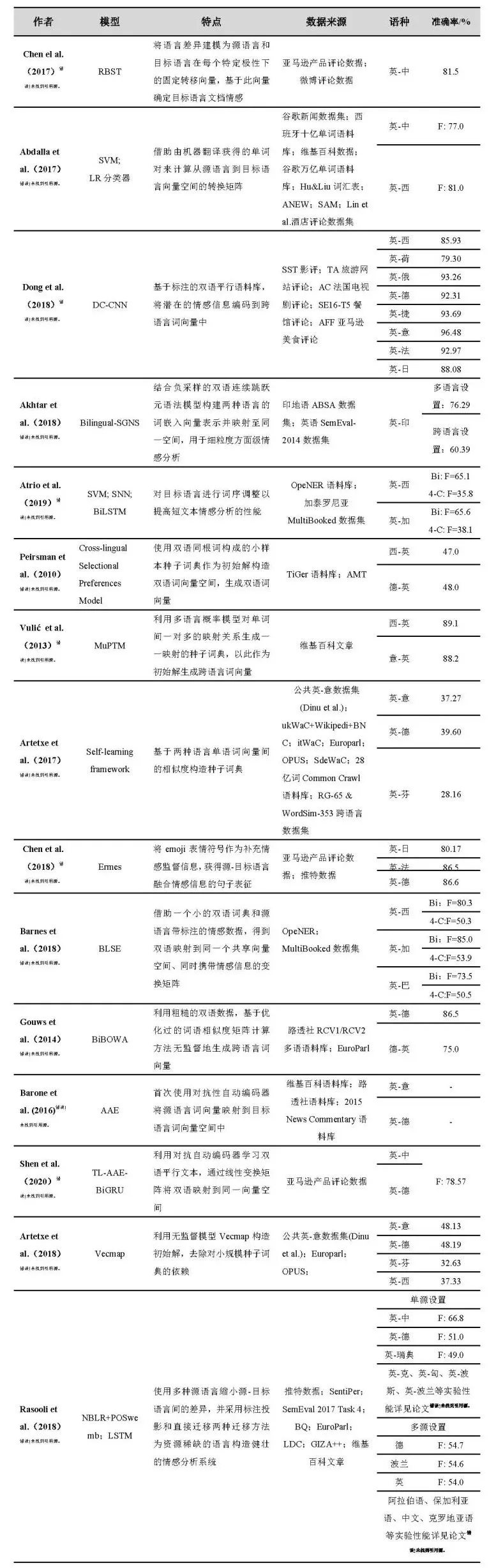

由于目标语言和源语言之间存在固定的内在结构(Fixed Intrinsic Structure)和不同的术语分布(Term Distribution),即便采用现最好的翻译系统,机器翻译的失误仍然会带来约10%的文本情感扭曲或反转现象[18]。为了克服机器翻译质量对跨语言情感分析的影响,相关研究尝试对基于机器翻译的跨语言情感分析进行改进,具体的改进思路有:借助对源语言情感词典的翻译[19]、对源语言的训练集进行优化[20]、设置标准数据集对机器翻译进行优化[21]、使用多种源语言的标记数据[22]以及将目标语言未标记数据[23]添加到训练集。表1列举了部分早期跨语言情感分析的代表研究,其中*标注的是近年来关于基于机器翻译改进的相关代表性论文。

He等(2011)[19]为了解决基于机器翻译的CLSA存在的泛化问题(Generation Problem),尤其是当源语言和目标语言的文本属于不同领域时效果不佳的问题,提出一种弱监督的潜在情感模型(Latent Sentiment Model,LSM),在隐含狄利克雷分布(Latent Dirichlet Allocation,LDA)中融入从源语言的情感词典中通过机器翻译得到的目标语言可用的情感先验知识。LSM将该情感先验知识纳入LDA模型中对目标语言文本进行情感分类,LDA主题分类的类别数等于情感分类的类别数。

为了使源语言的训练集合样本更接近目标语言的文本,Zhang等(2016)[20]提出对源语言的训练集合样本进行优化选择(refinement),通过相似度计算将与目标语言高度相似的样本作为改进后的训练样本,构建一个以目标语言为中心的跨语言情感分类器。该方法通过选择有效的训练样本来消除源语言和目标语言之间的语义分布差异。Adel等(2017)[21]研究机器翻译引入的噪声对CLSA的影响,提出通过设置标准数据集对机器翻译进行优化,并以英语为源语言、阿拉伯语为目标语言进行实验。首先通过英语的标记数据集训练多个机器学习算法,例如朴素贝叶斯、支持向量机,再用训练好的模型预测目标语言的情感类别,选出表现最好的模型;接着通过该模型确定噪声与情感分类精度之间的关系。研究表明,该方法训练出的最优模型能够为阿拉伯语这类资源稀缺的语种生成可靠的训练数据。

基于机器翻译方法的改进,Hajmohammadi等人进行一系列探索[22][23][24]。首先,从增加源语言种类入手,于2014年提出一种基于多源语言多视图的CLSA模型[22]。该模型将多个源语言的标记数据作为训练集,尝试克服由于单一源语言的机器翻译所导致的词汇覆盖(vocabulary coverage)问题,即由于不同语言之间的语义表达和书写风格不同使得从单一源语言翻译的文本不能覆盖目标语言所有的词汇,而有可能从另一源语言的翻译中得到覆盖。随后,在2015年提出基于机器翻译将目标语言的未标记数据整合到学习过程中,进一步提高性能[23]。利用主动学习从翻译成源语言的目标语言无标记文本中选择信息量最大、最可信的样本进行人工标记,丰富只有源语言带标记文本的训练数据。最后,为了克服源语言和目标语言的术语分布不同的问题,提出一种基于多视图的半监督学习模型[24],把多种源语言的标记数据作为训练集,通过自动机器翻译从源语言和目标语言的文档中创建多个视图,并将目标语言中未标记的数据合并到多视图半监督学习模型中,从而提高跨语言情感分析的性能。

表1 早期跨语言情感分析的代表研究

Table 1 Representative Researches on Early Cross-lingual Sentiment Analysis

上述基于机器翻译的CLSA改进方法中看出,为了解决基于机器翻译的CLSA存在的泛化问题、词汇覆盖问题、源语言和目标语言之间的语言鸿沟问题,相关研究工作方法进行了一定的探索,这些探索针对特定的问题开展,取得了较好的效果,然而仍然没有获得一个一致的解决机器翻译根源性问题的方案。这些改进工作大多采用亚马逊产品评论数据集,数据集的多样性不够、难以全面支持和反映所改进方法的性能效果。

1.2 基于平行语料库的方法

平行语料库是由相互翻译的文本组成的语料库。基于平行语料库的CLSA无需借助翻译系统,而是通过平行或可比语料(Comparable Corpora)为基础完成源语言和目标语言的空间转换[25],是早期CLSA的主要方法之一。

图2 基于平行语料库的CLSA方法示意图(引自[26])

Fig. 2 Structure of CLSA based on parallel corpora

平行语料库包括了大量平行句对的集合,通过将平行句对中两个对齐的单词连接起来,构建语言间的映射关系。例如,图2(b)是两个表达相同语义的中英文句子,即一组平行句对。句对中的中文单词“快乐”与英语单词“happy”对应,可以说这两个单词对齐(word-aligned)。图2(a)将平行语料库中两种语言的单词作为节点,通过语料库的单词对齐及同义词、反义词等信息建立节点间联系,从而构建语言间的关系。

表1中带&标注的是近年来基于平行语料库的CLSA研究,主要思路为:借助目标语言的未标记数据[29]、通过平行数据的学习来扩大词汇覆盖率[30]、通过平行语料库生成目标语言的情感词典[26]、以及借助少量并行数据和大规模的不并行数据[31]。

Lu等(2011)[29]首次提出借助无标注的平行语料库来提高基于有标注的平行语料库获得的情感分类器性能。Lu认为未标注的语料库中的平行语句也应具有相同的情感极性,因此提出在句子级别同时联合每种语言的标记数据和未标记平行数据,使用标记数据基于最大熵分类器进行EM迭代更新,逐步提高两个单语分类器对未标记平行语句的预测一致性,以最大化平行语料库的预测一致性。实验表明,该方法同时改进了两种语言的情感分类准确率约3.44%-8.12%。

然而,Lu等人要求两种语言都有带标记的数据,这些数据通常不易获得。因此,Meng等(2012)[30]提出一种生成性跨语言混合模型(Generative Cross-lingual Mixture Model,CLMM),去除对目标语言标记数据的要求,不依赖不可靠的机器翻译来标记数据,而是利用双语并行数据弥合源语言和目标语言之间的语言差别。CLMM通过拟合参数以最大化双语平行数据的可能性,从未标记的平行语料库中学习情感词,显著提高了词汇覆盖率,从而提高跨语言情感分类的准确率。

将情感信息从源语言传递到目标语言的过程中,现有方法[27][28]使用少量词汇来翻译源语言,从而导致目标语言的情感词汇覆盖率较低。为了解决该问题,Gao等(2014)[26]提出一种基于平行语料库和词对齐构建的双语词图方法,能够从现有源语言(英语)情感词典中学习到目标语言的情感词典,从而将情感信息从英语情感词转移到目标语言的情感词上。

由于大规模文档对齐(Document-aligned)或者句子对齐(Sentence-aligned)的平行数据很难获得,通常只存在少量的平行数据以及大量不平行的各语言下的文本。Zhou等[31]提出一种子空间学习框架来同时学习源语言和目标语言间少量的文档对齐数据和大量的非对齐数据。研究者认为,文档对齐的并行数据在两种不同的语言中描述着相同的语义,它们应该在相同的分类任务中共享相同的潜在表示,通过此共享表示来减少源语言和目标语言之间的语言差距[31]。

上述基于平行语料库的研究,共性之处在于借助平行语料库建立两种语言的单词对应关系,从语义和概念上弥合源语言和目标语言之间的术语分布和结构差异,避免机器翻译的噪声问题。同时需注意到,传统基于平行语料库的方法需要大量并行或标记数据,往往不易获得;故上述相关工作研究通过采用可比语料库、非并行数据和未标记数据,减少对并行标记数据的依赖。

1.3 基于双语情感词典的方法

文档级或句子级的机器翻译容易引入较大的翻译误差,而词语级别的机器翻译准确率较高,因此,双语情感词典(Bilingual Sentiment Lexicon)被提出用于跨语言情感分析。基于双语情感词典的CLSA,首先构建双语情感词典,再计算目标语言文本中各个单词的情感分值得到总文本的情感分值,作为文本情感判别的重要依据。

基于双语情感词典的CLSA属于一种无监督方法,无需借助源语言和目标语言的标注数据,天然地具有一定的优势。近年来,一些研究学者致力于研究双语情感词典的构建这一子任务,进而完成CLSA任务。

构造双语情感词典的主要方法有:基于机器翻译、基于同义词词集(Synset)和基于平行语料库的方法。双语情感词典的生成质量评估主要采用覆盖率和准确率2种标准:覆盖率是统计生成的情感词典所包含的单词在实验所用单词表中所占比例;而准确率是统计分类正确(积极/消极)的单词在实验所用单词表中的所占比例。

基于机器翻译的双语情感词典构建,将已有单语情感词典经机器翻译后得到跨语言情感词典,实现较为简单。Darwich等(2016)将印尼语WordNet和英语WordNet通过机器翻译后映射得到马来西亚语的情感词典。该方法对于资源较为丰富的语言有较好的表现,但是对于资源相对稀缺的语言表现并不理想:经过5轮迭代后生成的情感词典的准确性只有0.563[32]。

基于同义词词集的双语情感词典构建利用现有单语同义词词集,经过一些映射方法得到跨语言情感词典。Nasharuddin(2017)[33]设置跨语言情感词典生成器(Cross-lingual Sentiment Lexicon Acquisition)将马来西亚语情感词典根据同义词集和词性映射到英语情感词典中形成双语词典。Sazzed(2020)[34]通过英语WordNet和孟加拉语评论语料库获取孟加拉语近义词集,并以此生成孟加拉语情感词典。

基于平行语料库的双语情感词典构建是近年来较为常用的双语情感词典构建方法。该方法通过对两种语言的平行语料库进行分析和抽取后构建双语情感词典。Vania(2014)[35]等人通过英语和印度尼西亚语的平行语料库,根据抽取得到的情感模式(Senti-Pattern)进行情感单词抽取,从而构造双语情感词典。Chang等(2019)[36]使用多语言语料库基于Skip-gram生成得到保留上下文语境的单语词向量表示,而后计算英语词向量与其对应的翻译为中文的词向量之间的最优转化矩阵,通过这个转化矩阵将英语的情感单词词向量转化为中文空间中的词向量,从而利用余弦相似度构造中英跨语言情感词典。

完成双语情感词典构建后,研究者们基于双语情感词典开展跨语言情感分析研究。例如,Gao等(2015)[26]提出LibSVM模型,结合双语情感词典对NTCIR数据集中的数据进行情感分类。He等(2018)[37]基于中越双语词典利用卷积神经网络对中越新闻进行情感分析研究。Zabha(2019)[38]等使用中文-马来语双语情感词典,利用情感得分统计(Term Counting)方法对马来语的推特数据进行情感分析。

上述研究表明,基于双语情感词典能够进行跨语言情感分析,但也存在一定局限性:跨语言情感分析的性能一方面依赖于所构建的双语情感词典的质量,另一方面还受到跨语言情感预测所使用方法/模型的影响,例如采用卷积神经网络或基于情感得分统计的方法等。同时也必须看到,基于双语情感词典的CLSA属于一种无监督的方法,相比其他有监督方法具有其天然优势。

2

跨语言词嵌入生成研究

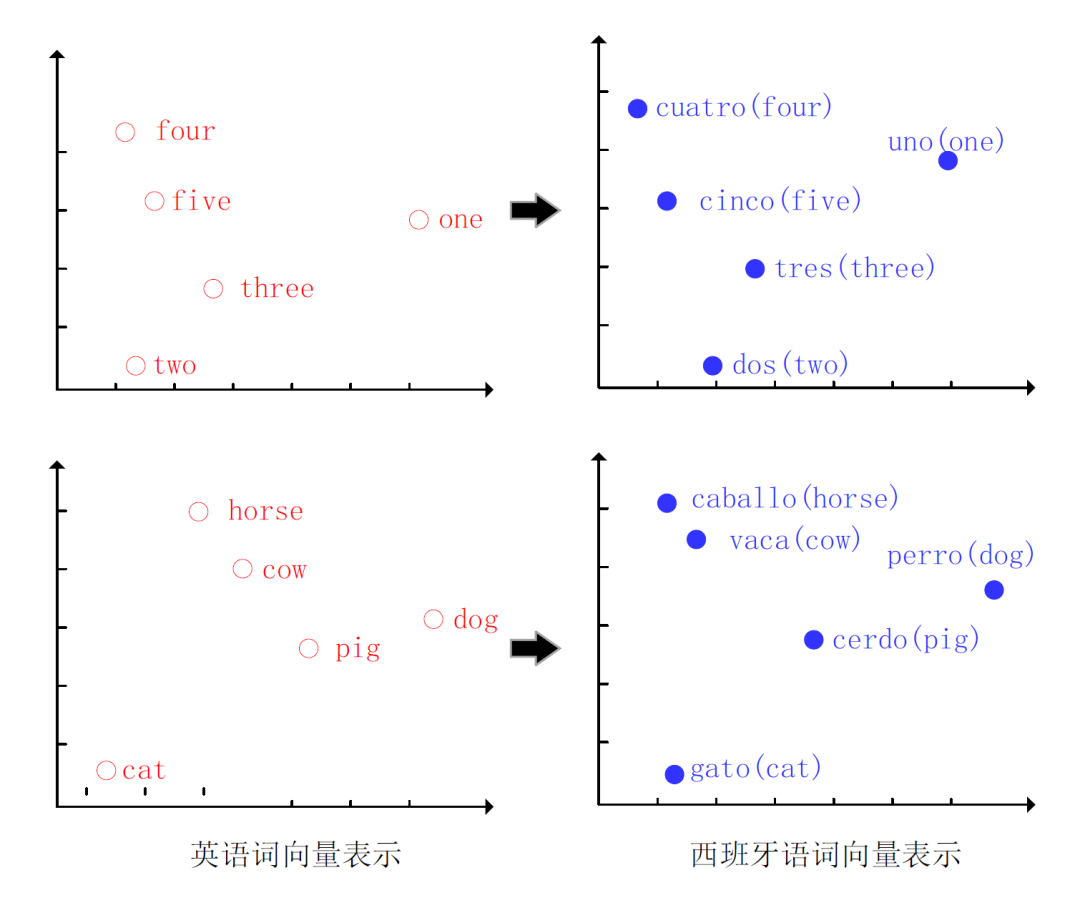

随着分布式词向量表示模型Word2Vec[4]、GloVe[39]和ELMO[40]被相继提出,文本的语义通过词嵌入(Word Embedding)向量进行表示。跨语言词嵌入(Cross-lingual Word Embedding,CLWE)能够获得源语言和目标语言在同一语义空间下的词向量表示。基于CLWE,含义一样、来自不同语言的单词具有相同或相似的向量表征。图3展示了英语和西班牙语的一组单词在特征空间中的CLWE分布情况,可以看到,语义相同的双语单词在空间中的位置彼此靠近,如西班牙单词“gato”与英文单词“cat”的位置相比于“dog”或“pig”更为接近。基于CLWE的跨语言情感分析依赖于CLWE的生成质量。近年来,许多研究工作致力于开展CLWE生成研究。这个小节重点谈论CLWE的相关工作。

图3 英语和西班牙语的CLWE示意图(引自[44])

Fig.3 Schematic of CLWE in English and Spanish

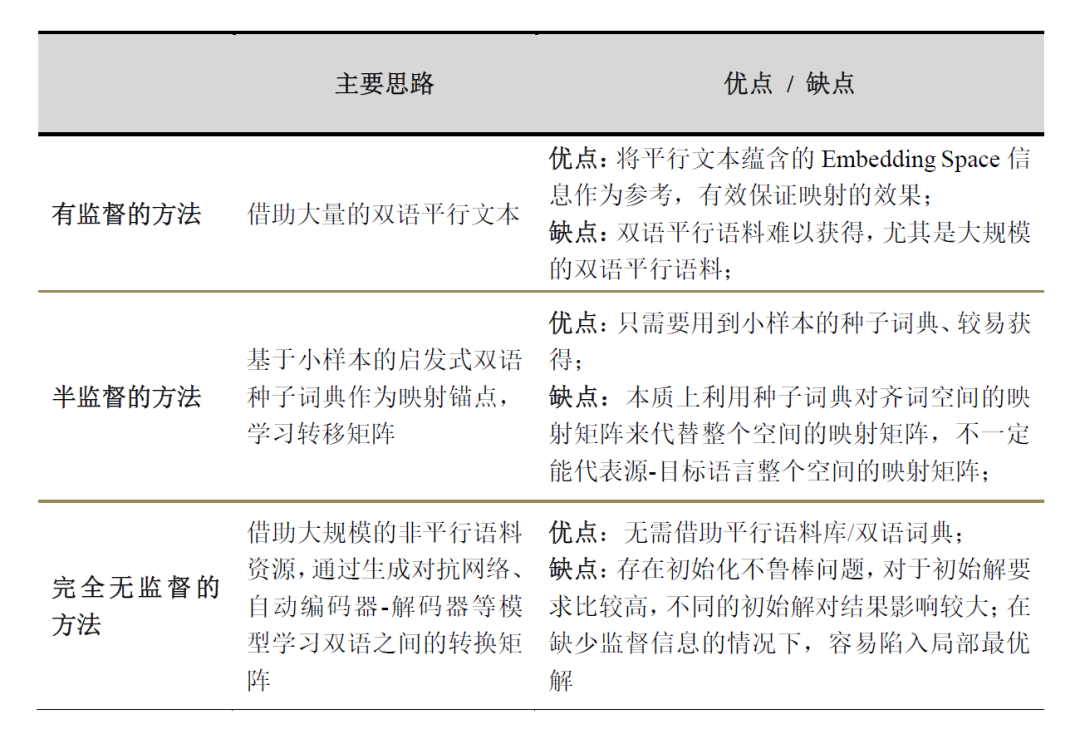

早期的CLWE主要采用有监督方法,依赖于源语言和目标语言之间昂贵的人工标注语料,例如词级对齐[41]、句子级对齐[42]以及文档级对齐[43]的跨语言语料(平行语料库或种子词典)作为跨语言的监督信号。然而对于大多数语言,这样的平行语料和种子词典并不容易获得。因此,半监督方法被提出来,尝试用更小规模的语料或者种子词典减少对监督信息的依赖,并在一些语言对上取得了较好的结果,例如在英-法双语词典生成任务中获得了37.27%的翻译准确率,在英-德双语词典生成任务中获得接近40%的翻译准确率[44]。近年来,无监督的方法成为跨语言词嵌入生成的研究热点[45][46][47][48],主要原因在于无监督方法无需借助任何平行语料库或者种子词典,适用的语种范围更广泛,可移植性更强。表2总结了有监督、半监督和无监督跨语言词嵌入生成的不同研究思路,并总结每种方法的优缺点。下面分别具体阐述每种方法。

表2 跨语言词嵌入生成方法分类及总结

Table 2 Classification and summarization of cross-lingual word embedding generation

2.1 基于有监督的跨语言词嵌入生成

有监督的CLWE模型需要依靠大量的双语平行文本,根据生成CLWE方法和模型的不同,现有工作在对情感表达的语言差异建模[49]、借助机器翻译的单词词对[50]、在跨语言词向量中加入情感信息[51]、基于方面级(Aspect-level)细粒度的跨语言词嵌入[52]、以及研究单词的词序调整对跨语言词嵌入生成的影响[53]等方面开展有监督的跨语言词嵌入生成研究。

Chen等(2017)[49]认为在现有的跨语言情感分析中语言的差异性(Language Discrepancy)被大大忽略了,因此提出对情感表达中固有的语言差异进行建模,以便更好地进行跨语言情感分析。给定源语言及其翻译文档构成的混合情感空间,语言差异被建模为源语言和目标语言在每个特定极性下的固定转移向量,基于目标语言文档与其翻译副本之间的转移向量来确定目标语言文档的情感。

Abdalla等(2017)[50]采用Mikolov提出的向量空间矩阵转换的办法,通过借助由机器翻译获得的2000个单词对,计算从源语言到目标语言向量空间的转换矩阵。研究结果发现当单词对的翻译质量较低时,情感信息仍然是高度保存的,不影响词向量转换矩阵的生成质量。Dong(2018)[51]在Abdalla[50]工作的基础上,为了更好的适应跨语言情感分析任务,在生成跨语言词向量的同时加入了情感信息。基于标注的双语平行语料库,将潜在的情感信息编码到CLWE模型中。

现有大部分跨语言情感分析模型仅覆盖较粗糙的情感分析,如句子级情感分析、文档级情感分析。Akhtar等(2018)关注于更加细粒度的方面级(Aspect-level)情感分析[52],通过结合负采样的双语连续跳跃元语法的模型(Bilingual-SGNS)对两种语言进行词嵌入向量表示,使两种语言被映射到同一共享向量空间中。在方面级的多语言情感分析任务中,该模型达到了76%的准确率;在实体级跨语言情感分析任务中,该模型也达到了60%以上的准确率。

Atrio(2019)[53]注意到语言之间的词序存在差异,并研究词序对跨语言情感分析研究的影响。以英语为源语言,西班牙语和加泰罗尼亚语为目标语言的双语平行语料库作为数据集,对目标语言进行词序调整,包括名词-形容词调整(Noun-Adjective)和全部调整(Reordered)。研究发现,词序调整有助于短文本的情感分析任务,例如方面级或者句子级别,而不适用于文档级别的CLSA任务。

综上所述,有监督的CLWE生成模型的优点是能够将平行文本蕴含的嵌入空间(Embedding Space)信息作为参考,有效保证了双语空间的映射效果。

2.2 基于半监督的跨语言词嵌入生成

基于半监督的CLWE方法认为不同语言同一个含义的词嵌入向量之间具有相似性(isometry)。基于该假设,半监督方法舍弃了大量的平行语料,利用小样本的启发式种子词典。令种子词典表示为来作为映射锚点(anchor),

为源语言单词,

是

在目标语言对应的翻译词,每个单词表示为d维的向量,n是D中单词的个数。通过学习转移矩阵,使得与这两个空间尽可能相近,即优化以下目标函数:

![]()

其中,X和Y都是由单词组成的语言空间,X是源语空间,Y是目标语空间。W为d×d维矩阵,X和Y分别为d×n维矩阵。对于公式(1)目标函数的优化过程称为迭代阶段。得到W*以后,对于任意一个源语言单词wx,通过与转移矩阵W*点乘将其映射到空间Y中,然后利用聚类算法,如K-NN算法,找到该点的最近邻点wy,于是wy就是wx的互译词

根据采用的种子词典以及生成转移矩阵的方法不同,现有工作对于半监督CLWE生成的研究思路有:使用双语同根词[54]、基于多语言概率模型得到种子词典[55]、利用单语词向量的相似度构造种子词[44]、在CLWE中考虑emoji表情信息[56],以及考虑句子的情感信息[57]。

Peirsman(2010)[54]等人在构建双语词向量空间时舍弃了双语平行语料库或大样本双语词典,而是使用双语同根词(Cognates)构成小样本种子词典,并以此作为初始解构造双语词向量空间,生成双语词向量。Vulić(2013)[55]等人认为两种语言的单词映射关系存在一一映射关系或者存在一对多的映射关系。基于一一映射关系,Vulić直接构造一一映射的种子词典作为初始解;基于一对多关系,则使用多语言概率主题模型(Multilingual Problematic Topic Modeling)生成一一映射的种子词典,并只保留对称翻译词对作为初始解进行CLWE的生成。

Artetxe(2017)[44]等人基于两种语言的单语词向量之间的相似度构造种子词典,将相似度最接近的两个单词看做对应的翻译,并加入种子词典中。Artetxe的研究表明,基于构造好的初始解,通过迭代自学习方法能够从25个单词对的种子词典中得到高质量的CLWE映射;同时指出,初始解不够好时该方法容易陷入局部最优解,不适用于规模较小的CLWE生成。

Chen(2018)[56]等人认为微博和推特用户评论中的表情符号可以作为跨语言情感分析的纽带,提出一个基于表情的CLSA表征学习框架Ermes。Ermes在Word2Vec词向量模型的基础上,使用emoji表情符号来补充情感监督信息,基于注意力的堆叠双向LSTM模型,获得源语言和目标语言融合情感信息的句子表征。在这个过程中,需要借助机器翻译系统获得与源语言标注数据对应的目标语言伪平行语料。

Barnes(2018)[57]等人提出一种双语情感词嵌入(Bilingual Sentiment Embeddings, BLSE)表示,通过借助一个小的双语词典和源语言标注的情感数据,得到源语言和目标语言映射到同一个共享向量空间、同时携带情感信息的变换矩阵。以英语为源语言,西班牙语和加泰罗尼亚语为目标语言进行验证,BLSE能够借助源语言的情感信息提升CLSA性能,但是也容易在功能词的向量表示上分配太多的情感信息。

综上所述,基于半监督的CLWE方法舍弃了大量的平行语料,利用对齐的种子词典来学习语言映射矩阵,本质上是利用种子词典对齐词空间的映射矩阵来代替整个空间的映射矩阵,该方法存在一定的局限性。尤其是对于语义距离比较远的两个语种,利用种子词典学到的映射矩阵来代替整个空间的映射矩阵会引入较大的误差,例如英语和日语之间。因此,基于半监督方法的CLWE,应同时兼顾种子词典和词嵌入向量中丰富的信息,引导映射矩阵的学习。

2.3 基于无监督的跨语言词嵌入方法

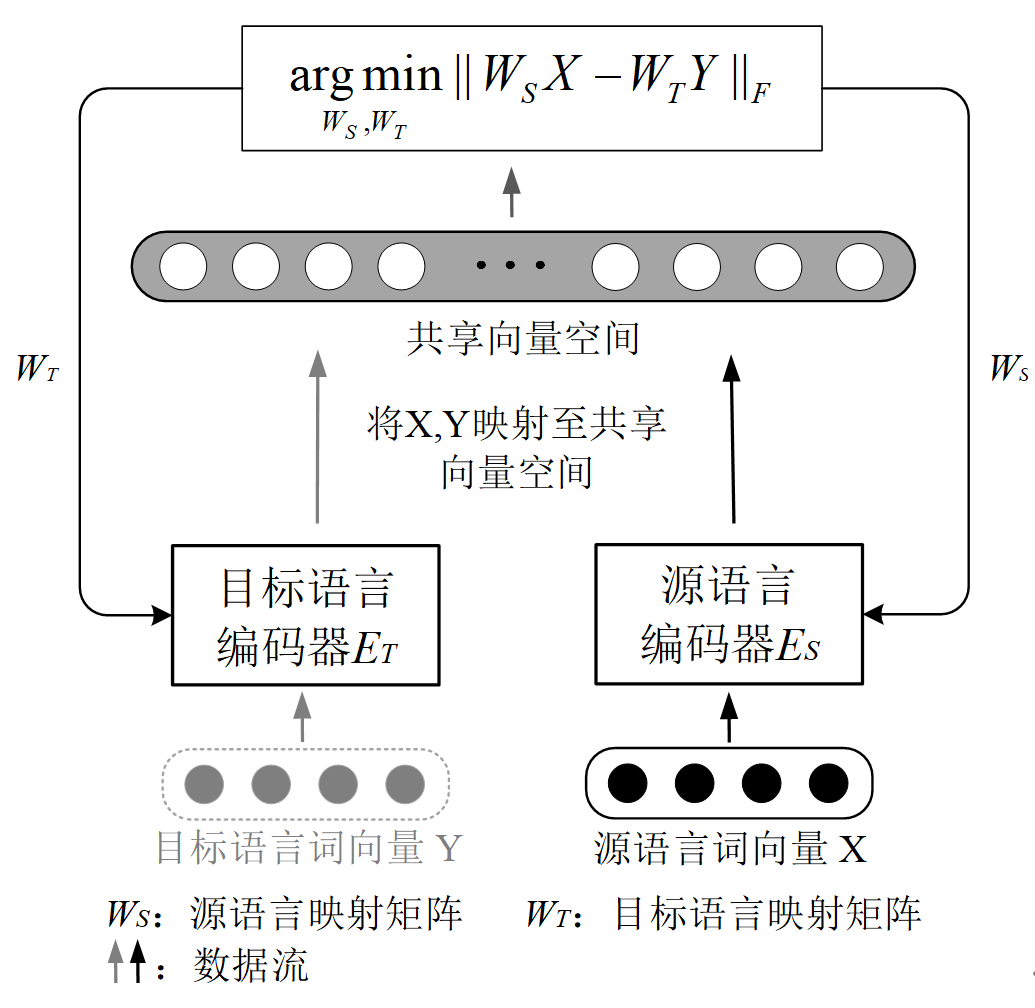

图4 基于无监督方法的CLWE结构示意图

Fig. 4 Structure of cross-lingual word embedding based on unsupervised approach

相较于有监督以及半监督的方法,基于无监督的CLWE生成无需借助双语平行语料,其主要思路是:借助大规模的非平行语料资源,通过生成对抗网络、自动编码器-解码器等模型挖掘两种语言表示之间存在的关系,并通过上述模型学习得到双语之间的转换矩阵,将两种语言的词嵌入表示映射至同一空间中,具体如图4所示。

现有研究对无监督的CLWE生成思路包括:优化词语相似度矩阵[58]、使用对抗性编码器[61][62]、优化迭代自学习的初始解[63]、引入同一语言家族的多个源语言等方法[64],实现以及提高无监督CLWE的性能。

Gouws等(2014)[58]发现有监督及半监督的CLWE普遍存在两个问题:一个是训练耗时过长,不适用于大规模数据集;第二是过分依赖双语平行语料库。因此,Gouws首次尝试将无监督方法应用到跨语言词嵌入中,即无需单词级别的双语平行语料库,提出一种BilBOWA模型生成CLWE。该方法在英语-德语、德语-英语CLSA任务中分别取得86.5%和75.0%的准确率,远高于Hermann等2013年提出的BiCVM模型[59]以及Chandar等2014年提出的BAEs模型[60]。同时,BilBOWA优化了词向量映射矩阵的计算,大大缩短了训练时间,仅需BAEs[60]训练时间的1/800。

Barone (2016)[61]首次尝试使用对抗性自动编码器(Adversarial Auto-Encoder, AAE)将源语言的词嵌入向量映射到目标语言的词嵌入向量空间中。该方法能够在一定程度上提高两种语言的语义信息转换,但是在不使用平行文本的训练下,实验结果并不理想。Shen(2020)[62]利用AAE学习双语的平行文本,通过线性变换矩阵将两种语言映射到同一共享向量空间,将其作为BiGRU模型的输入,获得最终的预测结果。将AAE引入BiGRU后,提升效果明显,在亚马逊产品评论数据集上的F1值达到了78.6%。

Artetxe(2018)[44]等人在半监督CLWE方法的基础上,提出一种无监督模型Vecmap来构造初始解,去掉对小规模种子词典的依赖。Vecmap模型基于假设:不同语言中具有相同语义的单词应该具有相同的分布,以此来构造初始解的单词对。该方法在英语-意大利语、英语-德语双语词典生成任务中均达到了48%的准确率,在英语-西班牙语双语词典生成任务中也获得了37%的准确率[63]。

Rasooli(2018)[64]等人在无监督的基础上考虑了语系家族对于CLWE的影响,选取来自同一语言家族、资源丰富的语言作为多个源语言,通过多种源语言的方法缩小目标语言和源语言之间的差异,并采用标注投影和直接迁移这两种不同场景下情感分析的迁移方法,为那些没有标记情感训练数据且机器翻译能力较小的语言设置健壮的情感分析系统。Rasooli等人发现,使用同一语系家族的语言能够提升跨语言情感分析任务的准确度,例如,斯洛文尼亚语和克罗地亚语、英语和瑞典语。

上述研究表明,基于无监督的CLWE能够获得较好的双语词嵌入向量,并且在下游CLSA任务上有着比较突出的表现。例如,BilBOWA模型[58]在英语-德语的CLSA中达到了85%以上的准确率。TL-AAE-BiGRU模型[62]在英语-中文、英语-德语的亚马逊评论数据集上达到78%以上的F1值。

但是,尽管基于无监督的CLWE无需借助双语平行文本或语料库,减少了对数据的依赖,在性能上也有较好的表现,仍存在一定的缺点。Søgaard[65]等人研究发现,基于无监督的CLWE模型对于语言对的选择非常敏感。对于部分语言对,依靠完全无监督的CLWE难以得到高质量的BWE词典。此外,无监督CLWE基于假设:不同语言间具有相同含义的单词,应具有相似的词嵌入向量,从而依靠单语下的词嵌入向量生成CLWE。这一假设对于语义和语法结构相差较大的两个语种之间不一定成立,例如英语-日语、西班牙语-中文语言对。因此,无监督的CLWE对初始解的要求较高,容易在迭代过程中陷入局部最优解、甚至较差解中。

表3总结整理了上述基于有监督、半监督和无监督的基于跨语言词嵌入的CLSA相关研究工作。

表3 基于跨语言词嵌入的跨语言情感分析

Table 3Cross-lingual Sentiment Analysis based on CLWE

3

基于生成对抗网络的方法

生成对抗网络(Generation Adversarial Network,GAN)由Goodfellow等人在2014年提出错误!未找到引用源。,在图像生成任务取得了巨大成功,近年来被应用于CLSA。

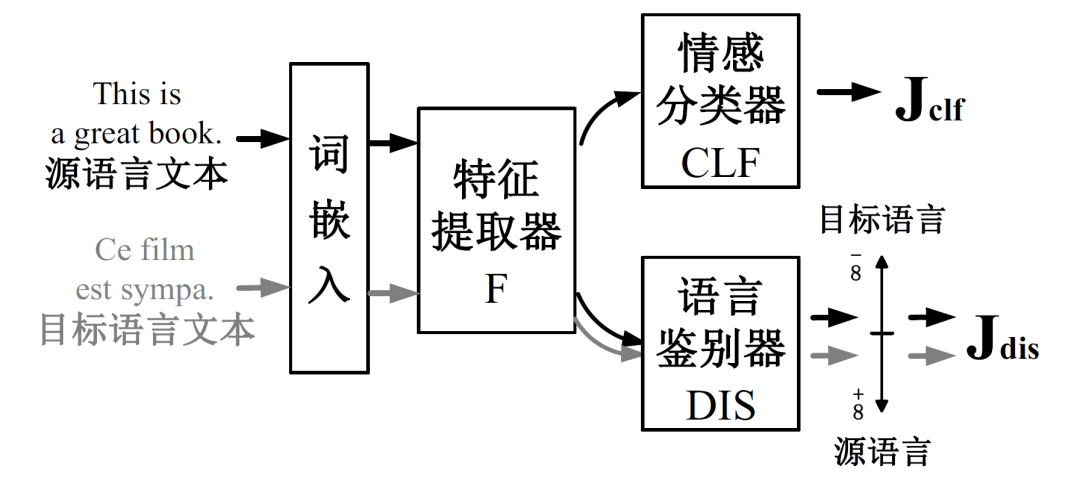

基于GAN的跨语言情感分析,其核心思想是生成-对抗,如图5所示,一般具有三个模块:特征提取器(Feature Extractor)、语言鉴别器(Language Discriminator)和情感分类器。具体地,特征提取器作为生成器、提取文本特征;语言鉴别器判别特征来源是源语言还是目标语言;二者组成生成对抗网络并进行训练。每次迭代中,鉴别器首先提升鉴别语言能力,而特征提取器随后尽力混淆语言鉴别器,训练结果是特征提取器使得语言鉴别器完全无法鉴别语言,即认为它能提取语言无关特征,能将该特征运用于跨语言的情感分类。最后,特征提取器和情感分类器组合并输入源语言的带标注数据进行训练,最终实现对目标语言的情感分析。

图5 基于生成对抗网络的跨语言情感分析模型

Fig. 5 Structure of cross-lingual sentiment analysis based on GAN

基于GAN的CLSA研究具有代表性的模型是Chen等人提出ADAN[67]和Feng提出的CLIDSA/CLCDSA[70]。同时,生成对抗网络的变种也被广泛应用于跨语言情感分类,如条件生成对抗网络(Conditional GAN),基于Wasserstein距离的Wasserstein GAN模型等。

Chen等(2018)首次提出一种对抗深度平均网络模型(Adversarial Deep Averaging Network, ADAN)[67],通过特征提取器和语言鉴别器的多次迭代提取源语言和目标语言中的语言无关特征。在对抗学习中尝试最小化源语言和目标语言分布的Wasserstein距离,来保证特征提取器能够提取出源语言和目标语言的语言无关特征提取。

受ADAN模型[67]启发,Antony(2020)[68]提出一个用多种资源丰富语言的单语数据集训练得到语言不变的情感分析器(Language Invariant Sentiment Analyzer, LISA)。LISA首先使用MUSE ( Multilingual Unsupervised and Supervised Embeddings)中的无监督方法[69],将其他语种的语义空间对齐到英语的语义空间,进而建立多语言词嵌入。LISA模型由提取特征的多语种序列编码器、鉴别特征语种的语言鉴别器和预测情感的情感分析器构成,通过编码器和鉴别器的对抗训练优化交叉熵损失函数。结果表明,LISA模型不适用于零样本学习,但在有限数据下可实现最优性能。

Feng(2019)[70]借助多个语言多个领域的源语言标注数据和目标语言的大量无标注数据,提出一个端到端的基于自动编码-解码器的跨语言跨领域情感分析(Cross Lingual Cross Domain Sentiment Analysis, CLCDSA)模型。区别于Chen等人使用ADAN或者LSTM作为语言特征提取器[67],CLCDSA模型利用自动编码-解码器作为语言特征提取器,对语言建模(language modeling),并从源语言和目标语言大量的无标注数据中提取语言无关特征。CLCDSA在英-法、英-德、以及英-日德亚马逊评论数据集分别取得84.6%、88.0%和81.9%的CLSA准确率。

Wang(2018)[71]提出了一种基于对抗性跨语言多任务学习(Adversarial Cross-lingual Multi-task Learning)的个性化微博情绪分类模型。该模型旨在解决现有大多数微博情感分类工作在单语数据集中缺少个人数据的问题,利用用户在新浪微博、推特等不同平台发表的不同语言的帖子作为数据源,使用对抗学习分别训练语言无关编码器和特定语言编码器,分别提取用户的语言无关特征以及特定语言特征,提高CLSA分析性能。

Kandula等[72]从域对抗神经网络DANN(2016)[73]和条件对抗领域迁移CDAN(2018)[74]获得启发,在2021年提出了一种端到端的、基于条件语言对抗网络(Conditional Language Adversarial Network, CLAN)的CLSA模型。情感分类器接受语言模型提取的特征,同时将情感分类器的情感预测作为条件和提取的特征进行互协方差运算输入语言鉴别器。通过语言模型和鉴别器的条件对抗训练对模型的所有部件进行共同优化,多次迭代提升提取特征的语言无关性,进而提高预测正确率。Pelicon等(2020)[75]使用斯洛文尼亚语数据集训练了基于多语言BERT的新闻情感分类模型。该模型在微调前加入了中间处理步骤,对掩码语言模型和情感分类任务进行联合学习,直接用情感信息丰富BERT模型,获得了高质量的输入表示。同时,模型分别测试了用新闻开头、开头结尾和全文生成文档表示的方法,以克服BERT模型不能有效处理长文档的缺陷。

基于GAN的跨语言情感分析巧妙地借助生成-对抗思想实现跨语言的情感知识迁移,在英-德、英-法语言对上达到83%以上的准确率,但是不同语种之间的性能差异较大、应用于不同语种时需要重新调参数,导致语言的泛化性支持不够。

4

基于预训练模型的方法

近年来,以ELMo (2018)[40]、BERT (2019)[76]、和GPT-3 (2020)[77]为代表的预训练模型(Pre-trained Model, PTM)被相继提出,并被应用到CLSA领域。相关研究尝试基于PTM构建一个精通各种语言的模型。预训练模型本质上是一种迁移学习(Transfer Learning),包括预训练和微调两个步骤:首先在原任务上预先训练一个初始模型,然后在下游任务(目标任务)上继续对该模型进行精调(Fine-tune),从而达到提高下游任务性能的目的。预训练阶段使用自监督学习技术,从大规模数据(数亿个参数)中学习到与具体任务无关的初始模型;微调阶段则针对具体的任务进行修正,得到任务相关的最终模型。

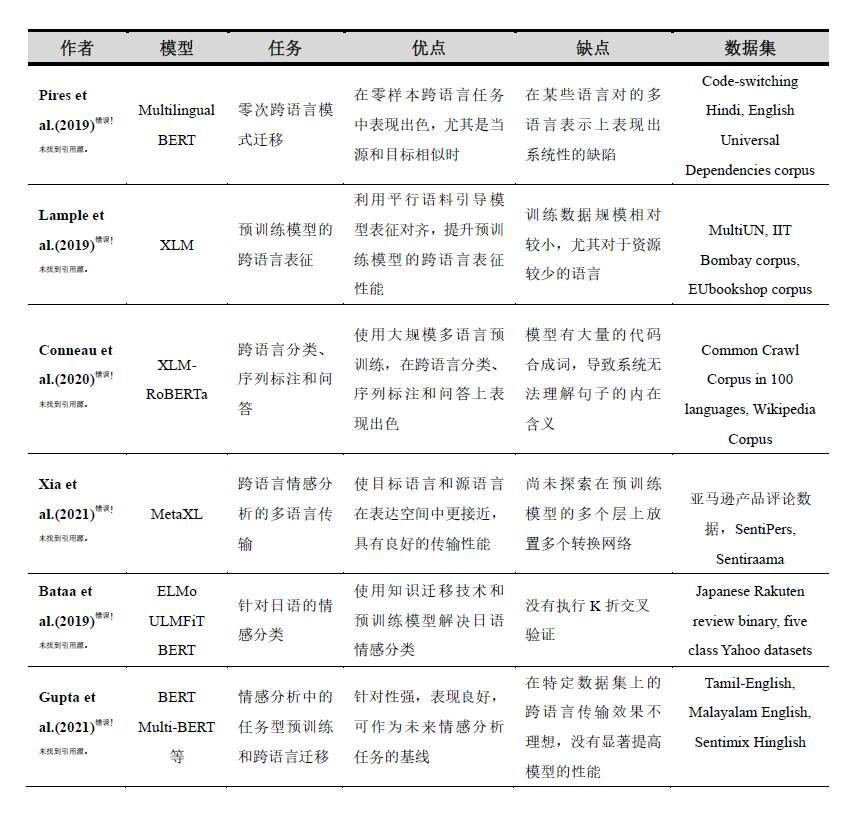

预训练模型在CLSA上的优势总结为3个方面[78]:(1)利用海量的无标注语料学习到通用的语言表征和更多的先验知识,有助于提升下游CLSA任务的效果;(2)PTM提供了较好的模型初始化参数,加快模型的训练并提升效果;(3)预训练可以视为一种正则化的方法,避免了下游任务在小数据上的过拟合风险,有更好的泛化能力。表4整理了2019年以来基于预训练模型的CLSA相关代表性研究,包括Multilingual BERT[79]、XLM[80]、XLM-RoBERTa[81]、MetaXL[82]等模型,分析这些模型应用在CLSA中的优缺点和采用的实验数据集。

表4 基于预训练模型的CLSA研究

Table 4 Cross-lingual Sentiment Analysis based on Pre-Trained Model

多语言BERT(Multilingual BERT, Multi-BERT)由Devlin等人于2018年提出[83],是由12层Transformer组成的预训练模型,使用104种语言的单语维基百科页面数据进行训练。值得注意的是,Multi-BERT训练时没有使用任何标注数据,也没有使用任何翻译机制来计算语言的表示,所有语言共享一个词汇表和权重,通过掩码语言建模(Masked Language Modeling)进行预训练。Pires等人[79]对Multi-BERT进行大量探索性的实验,发现Multi-BERT在零样本跨语言模型任务上表现出色,尤其是在相似语言之间的进行跨语言迁移时效果最好。然而,Multi-BERT在某些语言对的多语言表示上表现出系统性的缺陷(systematic deficiencies)。

为提高预训练模型的跨语言表征性能,Lample等(2019)[80]基于跨语言模型(Cross-lingual Language Model)提出了三种预训练任务,分别是因果语言模型(Causal Language Modeling, CLM)、掩模语言模型(Masked Language Modeling, MLM)和翻译语言模型(Translation Language Modeling, TLM)。其中,CLM和MLM是无监督方式,只依赖于单语言数据来学习跨语言表示;而TLM是有监督方式,不考虑单语种的文本流,而是借助平行语料数据提高跨语言模型的预训练效果。训练时随机遮盖源语言句子和目标语言句子中的一些单词,当预测被遮盖的词时,TLM首先通过该句子的上下文进行推断,若推断失败,TLM还能够借助对应源句子的翻译内容,以此引导模型将源语言和目标语言的表征对齐。实验结果表明,TLM作为有监督方法,以高出平均准确率4.9%的优势刷新了跨语言自然语言推断任务 (Cross-lingual Natural Language Inference, XNLI)的最优记录。

在XLM基础上,Conneau等(2020)[81]在次年提出了一种基于Transformer的多语言掩码模型XLM-RoBERTa,证明了使用大规模多语言预训练的模型可以显著提高跨语言迁移任务的性能。相较于XLM,XLM-RoBERTa主要在三个方面进行改进:(1)增加语种数量和训练数据集的数量,一共使用了100种语言、大小为2.5TB的大规模文本数据集,以自监督的方式训练跨语言表征;(2)微调过程中使用多种语言的标注数据,以提升下游任务的性能;(3)调整模型的参数,以抵消不利因素:使用跨语言迁移来将模型扩展到更多的语言时,可能导致模型理解每种语言的能力受限。实验表明XLM-RoBERTa在跨语言分类、序列标注和知识问答三个基准测试中取得了迄今为止最好的结果,在资源缺乏的语种上表现也非常出色。XLM-RoBERTa的缺点是使用该模型可能有大量的代码合成词(Code Mixed Words),导致系统无法理解句子的内在含义[84]。

基于预训练模型的CLSA研究属于一种迁移学习,需要大规模的单语语料进行预训练或者一定数量的标注数据进行精调。因此,对于资源匮乏的语言,其迁移学习效果并不理想。此外,语言之间的表示差距(Representation Gap)进一步加剧了资源匮乏语言的迁移学习难度。为了解决这一问题,Xia等(2021)[82]提出了一种基于元学习(Meta-learning)框架的MetaXL模型来弥合语言之间的表示差距,使得源语言和目标语言在表达空间上更加接近,提高跨语言迁移学习的性能。实验表明,与Multi-BERT和XLM-RoBERTa相比,MetaXL在跨语言情感分析和命名实体识别任务的性能平均提高了2.1%。未来工作中,可以通过增加源语言的数量、优化多个语言表示转换网络的位置来提高MetaXL的性能。

随着预训练模型在CLSA任务上表现优异,相关研究尝试将跨语言预训练模型应用于实践。Bataa和Wu(2019)[85]为解决在英语-日语语言对的CLSA性能较低问题,分别验证了ELMo[40]、ULMFiT[87]和BERT[76]预训练模型在英语-日语的跨语言情感分析效果。结果表明,基于预训练模型的性能相比基于三倍数据集的任务特定模型,例如RNN、LSTM、KimCNN、Self-Attention和RCNN,性能更好。在对话系统的多语言识别问题中,Gupta等(2021)[86]基于BERT[76]、Multilingual BERT[79]、XLM-RoBERTa[81]、以及TweetEval[88]四种预训练模型,分别比较其在两种语言对(泰米尔语-英语和马拉雅拉姆语-英语)中语码转换(Code-Switching)的效果。其中,TweetEval模型的主要思想是:基于RoBERTa预训练模型解决Tweet自媒体数据的七个分类任务,例如情感分析、情绪识别等。结果表明,TweetEval在任务特定的零触发(Zero-shot)预训练结果取得了较好的性能,优于利用BERT、Multi-BERT、XLM-RoBERTa三种模型的跨语种迁移效果。

综上所述,Multi-BERT、XLM和MetaXL等预训练模型在跨语言情感分析中被广泛应用并取得了较好的性能。然而,仍有一些问题亟待解决。首先,预训练模型由于包含的参数数量巨大,其训练和微调的代价都十分昂贵,对算力的要求也非常高[89],例如OpenAI的GPT-3模型包含了1750亿参数、DeepMind的Gopher模型包含了2800亿参数。海量的模型参数和算力要求使得预训练模型很难应用于线上任务(Online Services)和在资源有限设备(Resource-restricted Devices)上运行[78]。因此,PTM模型在跨语言情感分析上的大规模推广应用,也需要解决这一问题。PTM未来的一个发展方向是在现有的软硬件条件下,设计更有效的模型结构、自监督的预训练任务、优化器以及训练技巧,来达到提升的效果。其次,现有基于预训练模型的CLSA取得最好的效果是Multi-BERT在MLDoc(2018)[90]数据集的英-德语言对上,达到90.0%的准确率,最差的效果是在英-中语言对上,准确率仅为43.88%[91]。不同语言对之间的差异较大,说明预训练模型虽然通过大规模的数据中能够学习到语言无关的特征,并在零样本的CLSA任务、尤其是相似语言对之间的CLSA任务上取得了较好的性能,但仍然不能作为一个通用的泛化模型适用于不同的语言对。PTM应用于不同语言对时,需要根据语言的迁移进行微调,其缺点是低效性。每个语言对都有各自不同的微调参数。其中一种解决方案是固定PTM的原始参数,针对特定任务添加一个小的可调适配模块[92],未来更多高效的方法值得探索。总的来说,2019年至今,PTM在跨语言情感分析中取得了较好的性能,但仍有值得进一步探索的空间。

5

总结及展望

本文对跨语言情感分析的相关研究工作进行梳理总结,系统阐述了跨语言情感分析的研究路线,包括早期基于机器翻译及其改进的方法、基于平行语料库的方法、以及基于双语情感词典的方法;再到2013年后由于Word2vec、GloVe等词向量模型的提出,跨语言情感分析进入新的研究阶段:一方面,研究者们研究跨语言词嵌入向量生成模型,研究有监督、半监督、以及无监督的跨语言词嵌入生成;另一方面,相关研究利用生成-对抗思想提取多语言文本中与语言无关的特征,或者基于Multi BERT、MetaXL等预训练模型,从大规模的无标注数据中学习语言的表示,从而开展跨语言情感分析。

通过对现有CLSA研究的主要思路、方法模型、所覆盖语种、数据集以及性能进行总结归纳,从以下角度剖析CLSA研究存在的问题与挑战:(1)是否存在一个适用于所有语言的CLSA泛化模型;(2)针对不同的目标语言,能否能界定CLSA性能较好的源语言范围?(3)跨语言情感分析从早期基于机器翻译的方法,再到最近较为热门的基于预训练的方法,有哪些值得借鉴的地方。针对这三点问题,笔者结合对现有跨语言情感分析研究的思考,进行以下分析展望。

问题一,是否存在一个适用于所有语言的CLSA泛化模型。CLSA任务的提出,旨在解决资源稀缺的语言缺乏情感资源无法进行单语情感分析这一问题,但在全世界7000多种语言中,50%以上的语言为资源相对稀缺的语言。是否存在一个适用于所有语言的模型一直是CLSA需要回答的问题。

就目前的研究成果来看,不存在一个适用于所有场景的跨语言泛化模型(Cross-lingual Generalization Model)。如文中所述,针对CLSA的方法包括多种多样的方法,例如基于机器翻译、基于平行语料库、基于跨语言词嵌入的方法等,目前尚未找到一个在所有CLSA任务中表现均较好的泛化模型。例如,ADAN模型在英语-法语数据集上表现良好,但是在英语-日语数据集上表现较差[67];MUSE模型涉及到了包含45种语言的110个双语任务,但其表现在不同语言之间的表现差异较大[69]。产生这一现象的原因是不同语言之间的差异性,现有大部分研究将英语作为唯一源语言,因此针对不同的目标语言,很难基于一个统一的模型同时平衡英语和多种语言之间的差异。

同时,现有一些研究意识到此问题,通过增加源语言的语种来减少源与目标语言之间的差距。此外,Pfeiffer等人提出MAD-X模型,利用现有跨语言或多语言情感分析模型,通过调节器(Adapter)调节模型的参数和设置,使其能够有针对性的适用于特定的目标语言。基于MAD-X改进后,相比于未改进前,其F1值均有不同程度的提升,其中最高提高了6%[93]。Pfeiffer同时指出,属于同一语言家族的语言之间差异最小,同一语言家族的两种语言间进行CLSA能够最大程度提高MAD-X的性能。例如缅甸语和闽东语均属于汉藏语系,使用缅甸语作为源语言能够使得针对闽东语的跨语言情感分析准确率提升最大,反之亦然。

问题2,针对不同的目标语言,能否界定CLSA性能较好的源语言范围。该问题一直是CLSA研究的一大难点。现有大部分研究工作选择英语作为源语言,原因主要有以下两点:(1)英语的情感资源和标注语料较为丰富;(2)基于英语的单语情感分析相关研究更多,具有较多的模型选择。然而,固定源语言会带来语言差距不一致的问题,从而影响CLSA的性能。近年来,部分研究工作扩大源语言的选择范围,将日语、德语、西班牙语等多种语言作为源语言[27]。Rasooli在此基础上提出了一个新的假设:“是否使用同一家族的语言作为源语言,能够提高CLSA的准确性?”。Rasooli通过对斯洛文尼亚语和克罗地亚语的实验结果印证了这一假设(两者均属于印欧语系斯拉夫语族南部语支)[64]。

目前由于可选模型和语料库数量的限制,仅通过较少人工处理或机器预处理就能够用来作为源语言的语言数目相对较少。特别地,对于一些亚洲语言、非洲语言或欧洲语言,比如印地语、斯洛伐克语、乌尔都语,很难获取足够数量的训练数据进行实验[44][94][95]。在未来的工作中,能否提供包含更多语种的可用数据集,或许成为CLSA泛化模型研究的一大掣肘。如果可用数据集进一步丰富,则对于给定目标语言,如何选择源语言或许有望成为CLSA的热门研究之一。

问题3,CLSA从早期基于机器翻译的方法,再到近年来基于预训练模型的方法,如何横向对比不同的CLSA方法。

本文总结了CLSA的主要研究方法,这些方法各有其优缺点。一方面,基于Multi BERT等预训练模型的方法成为近年来CLSA研究的主流方法,相关研究在更多语言种类、更大数据集上进行了测试[79][80][81],将目标语言研究对象推广至中文、印地语、马来西亚语等资源更加稀缺或同英语距离更远的语种,验证其方法的性能;未来一段时间,基于预训练模型的CLSA方法及其改进是主流的研究方向。但是也需要看到,正如前文所述,基于预训练模型的方法对算力要求较高;处理不同语言对的CLSA任务时仍需进一步微调,应用于不同语言对时,性能差别较大。这些问题制约了基于预训练模型的CLSA研究的大规模推广应用。

另一方面,虽然早期一些经典的CLSA方法从提出至今已有十几年的历史,但对于CLSA的未来发展仍具有借鉴意义。例如,基于机器翻译及其改进的方法于2004年被提出,由于早期的机器翻译质量不高,容易受到机器翻译质量的影响;随着机器翻译系统的性能提高,该方法的性能也得到一定提升。基于预训练模型的CLSA对语言的数据量有一定要求,因此,基于机器翻译及其改进的方法仍具有应用价值:可作为一些数据资源匮乏小语种的首选方法、或者作为一种伪数据集的补充方法提升其他CLSA方法的性能等。又比如,基于结构对应学习的方法现在应用比较少,然而,所采用的源语言和目标语言的轴心词对选择思想,与无监督的跨语言词嵌入模型中初始解的选择思想殊途同归。因此,在未来的CLSA研究中,以预训练模型为主、多种方法同步应用丰富不同语言场景下CLSA需求是未来的发展趋势。在所有的CLSA方法中,需要解决源语言的选择较为单一、不同语言对的CLSA性能差别较大等共性问题。

最后,应注意到,跨语言情感分析的最终目的是为了借助源语言帮助目标语言实现情感分析。由于情感资源稀缺的语言的存在,使得跨语言情感分析是一件非常值得探索的方向。如果在跨语言情感分析模型所需耗费的的知识迁移代价太大、甚至远超于在单语下的情感分析所需要的耗费的人力物力,则违背了跨语言情感分析研究的初衷。同时,这也是检测未来跨语言情感分析模型能否在大规模语言上推广应用的重要指标之一。

参考文献:

[1] Yan Q, David A, Evans J G, Gergory G. Mining multilingual options through classification and translation[C]//Proceeding of AAAI. Menlo Park, CA: AAAI, 2004

[2] Xiaojun Wan. Using bilingual knowledge and ensemble techniques for unsupervised Chinese sentiment analysis[C]//Proceedings of the 2008 Conference on Empirical Methods in Natural Language Processing. United States: Association for Computational Linguistics, 2008: 553–561.

[3] Vulic I, Moens M F. Monolingual and cross-lingual information retrieval models based on bilingual word embeddings[C]//Proceedings of ACM SIGIR conference on RDIR. New York, NY, United States: Association for Computing Machinery, 2015: 363-372.

[4] Mikolov, Tomas & Chen, Kai & Corrado, G.s & Dean, Jeffrey. Efficient Estimation of Word Representations in Vector Space[C]//Proceedings of Workshop at ICLR. 2013 arXiv:1301.3781v3

[5] Balahur, A., Mihalcea, R., Montoyo, A. Computational approaches to subjectivity and sentiment analysis: present and envisaged methods and applications[J]. Computer Speech and Language, 2014, 28: 1–6. Balahur, A., Turchi, M.. Comparative experiments using supervised learning and machine translation for multilingual sentiment analysis[J]. Comput. Speech Lang, 2014, 28: 56–75.

[6] Banea, C., Mihalcea, R., Wiebe, J., Hassan, S. Multilingual subjectivity analysis using machine translation[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing. Honolulu, Hawaii: Association for Computational Linguistics, 2008: pp. 127–135.

[7] Martín-Valdivia, M.-T., Martínez-Cámara, E., Perea-Ortega, J.-M., Ureña-López, L.A. Sentiment polarity detection in Spanish reviews combining supervised and unsupervised approaches[J]. Expert Syst. Appl. , 2013, 40: 3934–3942.

[8] Prettenhofer, P., Stein, B. Cross-language text classification using structural correspondence learning[C]// Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. Uppsala, Sweden: Association for Computational Linguistics, 2010: pp. 1118–1127.

[9] Wan, X. Co-training for cross-lingual sentiment classification[C]//Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP. Suntec, Singapore: Association for Computational Linguistics, 2009: pp. 235–243.

[10] Balahur, A., Turchi, M. Comparative experiments using supervised learning and machine translation for multilingual sentiment analysis[J]. Comput. Speech Lang., 2014, 28: 56–75.

[11] Banea, C., Mihalcea, R., Wiebe, J. Multilingual subjectivity: are more languages better?[C]//Proceedings of the 23rd International Conference on Computational Linguistics. Beijing, China: Association for Computational Linguistics, 2010: pp. 28–36.

[12] Hajmohammadi, M.S., Ibrahim, R., Selamat, A. Density based active selftraining for cross-lingual sentiment classification[M]. In: Jeong, H.Y., Yen, N.Y., Park, J.J. (Eds.), Advanced in Computer Science and its Applications: Springer, Berlin, Heidelberg, 2014b: pp. 1053–1059.

[13] Martín-Valdivia, M.-T., Martínez-Cámara, E., Perea-Ortega, J.-M., Ureña-López, L.A. Sentiment polarity detection in Spanish reviews combining supervised and unsupervised approaches[J]. Expert Syst. Appl. 2013, 40: 3934–3942.

[14] Prettenhofer, P., Stein, B. Cross-language text classification using structural correspondence learning[C]//Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. Uppsala, Sweden: Association for Computational Linguistics, 2010: pp. 1118–1127.

[15] Hajmohammadi, M.S., Ibrahim, R., Selamat, A. Bi-view semi-supervised active learning for cross-lingual sentiment classification[J]. Inf. Process. Manag, 2014a, 50: 718–732.

[16] Pan, J., Xue, G.-R., Yu, Y., Wang, Y., 2011. Cross-lingual sentiment classification via Bi-view non-negative matrix tri-factorization[C]Proceedings of the 15th Pacific-Asia conference on Advances in knowledge discovery and data mining - Volume Part I, Berlin/Heidelberg: Springer-Verlag, 2011: pp. 289–300.

[17] Wan, X. Co-training for cross-lingual sentiment classification[C]//Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP. Suntec, Singapore: Association for Computational Linguistics, 2009: pp. 235–243.

[18] Wan, X. Bilingual co-training for sentiment classification of Chinese product reviews[J]. Comput. Linguist. , 2011, 37: 587–616.

[19] He, Y. Latent Sentiment Model for Weakly-Supervised Cross-Lingual Sentiment Classification[C]//Proceedings of ECIR, LNCS 6611, Berlin Heidelberg: Springer-Verlag, 2011: pp. 214–225.

[20] Zhang, P., Wang, S.G., Li, D.Y., 2016. Cross-lingual sentiment classification: Similarity discovery plus training data adjustment[J]. Elsevier B.V. , Knowledge-Based Systems, 2016, 107: 129-141.

[21] Al-Shabi, A., Adel, A., Omar, N., Al-Moslmi, T. Cross-Lingual Sentiment Classification from English to Arabic using Machine Translation[J]. (IJACSA) International Journal of Advanced Computer Science and Applications, 2017, Vol. 8, No. 12: 434–440.

[22] Hajmohammadi, M.S., Ibrahimn, R., Selamat, A., 2014. Cross-lingual sentiment classification using multiple source languages in multi-view semi-supervised learning[J]. Engineering Applications of Artificial Intelligence, 2014, 36: 195-203.

[23] Hajmohammadi, M.S., Ibrahimn, R., Selamat, A., Fujita, H. Combination of active learning and self-training for cross-lingual sentiment classification with density analysis of unlabelled samples[J]. Inf. Science, 2015, 317: 67-77.

[24] Hajmohammadi, M.S., Ibrahimn, R., Selamat, A. Graph-Based Semi-supervised Learning for Cross-Lingual Sentiment Classification[C]//Proceedings of ACIIDS, Part I, LNAI 9011, Switzerland: Springer International Publishing, 2015: pp. 97–106, 2015.

[25] 高影繁,王惠临,徐红姣.跨语言文本分类技术研究进展[J].情报理论与实践, 2010, 11: 126-128.

[26] Dehong Gao, Furu Wei, Wenjie Li, Xiaohua Liu, Ming Zhou. Cross-lingual Sentiment Lexicon Learning With Bilingual Word Graph Label Propagation[J]. Computational Linguistics, 2014, 41(1): 21-40.

[27] Duh, Kevin, Akinori Fujino, and Masaaki Nagata. Is machine translation ripe for cross-lingual sentiment classification? [C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics. United States: Association for Computational Linguistics, 2011: pages 429–433.

[28] Mihalcea, Rada, Carmen Banea, and Janyce Wiebe. Learning multilingual subjective language via cross-lingual projections[C]//Proceedings of the 45th Annual Meeting of the Association for Computational Linguistics. Prague: Association for Computational Linguistics, 2007: pages 976–983.

[29] Bin Lu, Chenhao Tan, Claire Cardie, and Benjamin K. Tsou. Joint bilingual sentiment classification with unlabeled parallel corpora[C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies-Volume1. United States: Association for Computational Linguistics, 2011: page320–330.

[30] Meng, Xinfan, Furu Wei, Xiaohua Liu, Ming Zhou, Ge Xu, and Houfeng Wang. Cross-lingual mixture model for sentiment classification[C]//Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics: Long Papers. Jeju Island: Association for Computational Linguistics, 2012a: pages 572–581.

[31] Guangyou Zhou, Tingting He, Jun Zhao, Wensheng Wu. A Subspace Learning Framework For Cross-Lingual Sentiment Classification With Partial Parallel Data[C]//Proceedings of the Twenty-Fourth International Joint Conference on Artificial Intelligence (IJCAI). Palo Alto, California USA: AAAI Press / International Joint Conferences on Artificial Intelligence, 2015: 1426-1432.

[32] Darwich, M., Noah, S. A. M., & Omar, N. Automatically generating a sentiment lexicon for the Malay language[J]. Asia-Pacific Journal of Information Technology and Multimedia, 2016, 5(1): 49-59.

[33] Nasharuddin, N. A. , Abdullah, M. T. , Azman, A. , & Kadir, R. A. English and Malay Cross-lingual Sentiment Lexicon Acquisition and Analysis[C]//Proceedings of ICISA: Information Science and Applications 2017. Singapore: Springer, 2017: pp 467-475.

[34] Sazzed, S. Development of Sentiment Lexicon in Bengali utilizing Corpus and Cross-lingual Resources[C]//Proceedings of 2020 IEEE 21st International Conference on Information Reuse and Integration for Data Science (IRI). Las Vegas, NV, USA: IEEE, 2020: pp. 237-244

[35] Vania, C., Moh. Ibrahim, & Adriani, M. Sentiment Lexicon Generation for an Under-Resourced Language[J]. Int. J. Comput. Linguistics Appl., 2014, 5(1), 59-72.

[36] Chang, C. H., Wu, M. L., & Hwang, S. Y. An approach to cross-lingual sentiment lexicon construction[C]//Proceedings of 2019 IEEE International Congress on Big Data (BigDataCongress) Milan, Italy: IEEE, 2019: pp. 129-131

[37] He, X. , Gao, S. , Yu, Z. , Liu, S. , & Hong, X. Sentiment Classification Method for Chinese and Vietnamese Bilingual News Sentence Based on Convolution Neural Network[C]//Proceedings of International Conference on Mechatronics and Intelligent Robotics. Cham: Springer, 2018: pp 1230-1239

[38] Zabha N I , Ayop Z , Anawar S , et al. Developing Cross-lingual Sentiment Analysis of Malay Twitter Data Using Lexicon-based Approach[J]. International Journal of Advanced Computer Science and Applications, 2019, 10(1): 346-351.

[39] Jeffrey Pennington, Richard Socher, Christopher D. Manning: Glove: Global Vectors for Word Representation. EMNLP 2014: 1532-1543

[40] Peters, M., Neumann, M., lyyer, M., Gardner, M., Clark, C., Lee, K. & Zettlemoyer, L. (2018). Deep contextualized word representations. In Proceedings of the 2018 conference of the North American Chapter of the Association for Computational Linguistics: Human language technologies (Volume1(Long Papers), pp.2227-2237). Association for Computational Linguistics, New Orleans, Louisiana. URL https://www.aclweborg/anthologv/N18-1202.

[41] Faruqui M, Dyer C. Improving Vector Space Word Representations Using Multilingual Correlation[C]//Proceedings of the 14th Conference of the European Chapter of the Association for Computational Linguistics. Gothenburg, Sweden: Association for Computational Linguistics, 2014: 462-471.

[42] Zou W Y, Socher R, Cer D, et al. Bilingual Word Embeddings for Phrase-Based Machine Translation[C]//Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. Seattle, Washington, USA: Association for Computational Linguistics, 2013: 1393-1398.

[43] Vulić I, Moens M F. Bilingual Word Embeddings from Non-Parallel Document-Aligned Data Applied to Bilingual Lexicon Induction[C]//Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 2: Short Papers). Beijing, China: Association for Computational Linguistics, 2015: 719-725.

[44] Artetxe M, Labaka G, Agirre E. Learning bilingual word embeddings with (almost) no bilingual data[C]// Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Vancouver, Canada: Association for Computational Linguistics, 2017: 451-462.

[45] Ruder S, Vulić I, Søgaard A. A survey of cross-lingual word embedding models[J]. Journal of Artificial Intelligence Research, 2019, 65: 569-631.

[46] Vulic I, Korhonen A L. On the role of seed lexicons in learning bilingual word embeddings[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Berlin, Germany: Association for Computational Linguistics, 2016: 247-257.

[47] Barone A V M. Towards cross-lingual distributed representations without parallel text trained with adversarial autoencoders[C]//Proceedings of the 1st Workshop on Representation Learning for NLP. Berlin, Germany: Association for Computational Linguistics, 2016: 121-126.

[48] 彭晓娅, 周栋. 跨语言词向量研究综述[J]. 中文信息学报, 2020, 34(2):16: 9-12.

[49] Chen Q, Li C, Li W, et al. Modeling Language Discrepancy for Cross-Lingual Sentiment Analysis[C]//Proceedings of CIKM 2017. New York, NY, United States: Association for Computing Machinery, 2017: 117-126.

[50] Abdalla M, Hirst G. Cross-Lingual Sentiment Analysis Without (Good) Translation[C]//Proceedings of the Eighth International Joint Conference on Natural Language Processing (Volume 1: Long Papers). Gothenburg, Sweden: Association for Computational Linguistics, 2017: 462-471.

[51] Dong X, Melo G D. Cross-Lingual Propagation for Deep Sentiment Analysis[C]//Proceedings of The Thirty-Second AAAI Conference on Artificial Intelligence(AAAI-18), Menlo Park, CA: AAAI, 2018:5771-5778.

[52] Akhtar M S, Sawant P, Sen S, etal. Improving Word Embedding Coverage in Less-Resourced Languages Through Multi-Linguality and Cross-Linguality: A Case Study with Aspect-Based Sentiment Analysis[J]. ACM Transactions on Asian and Low-Resource Language Information Processing, 2018, 18(2):1-22.

[53] ÀR Atrio, Badia, T., & Barnes, J. On the Effect of Word Order on Cross-lingual Sentiment Analysis[arXiv e-prints]. [2019] SEPLN 2019.

[54] Peirsman Y, Padó S. Cross-lingual induction of selectional preferences with bilingual vector spaces[C]//Proceedings of Human Language Technologies: The 2010 Annual Conference of the North American Chapter of the Association for Computational Linguistics. United States: Association for Computational Linguistics, 2010: 921-929.

[55] Vulić I, Moens M F. A study on bootstrapping bilingual vector spaces from non-parallel data (and nothing else)[C]//Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. Seattle, Washington, USA:Association for Computational Linguistics, 2013: 1613-1624.

[56] Chen, Z., Shen, S., Hu, Z., Lu, X., Mei, Q., & Liu, X. Ermes: Emoji-powered representation learning for cross-lingual sentiment classification [arXiv preprint]. [2018]. arXiv:1806.02557.

[57] Barnes, J., Klinger, R., Schulte, S., & Walde, S. Bilingual sentiment embeddings: joint projection of sentiment across languages[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Melbourne, Australia: Association for Computational Linguistics, 2018: 2483–2493.

[58] Gouws S, Bengio Y, Corrado G. BilBOWA: Fast Bilingual Distributed Representations without Word Alignments[J73].[2014] Eprint Arxiv.

[59] Hermann, Karl Moritz, and Phil Blunsom. "Multilingual distributed representations without word alignment." arXiv preprint arXiv:1312.6173 (2013).

[60] Chandar AP, Sarath, et al. "An autoencoder approach to learning bilingual word representations." Advances in neural information processing systems 27 (2014).

[61] Barone, A. V. M. Towards cross-lingual distributed representations without parallel text trained with adversarial autoencoders[arXiv preprint]. [2016]. arXiv:1608.02996.

[62] Shen, J., Liao, X., & Lei, S. (2020, April). Cross-lingual sentiment analysis via AAE and BiGRU[C]//Proceedings of 2020 Asia-Pacific Conference on Image Processing, Electronics and Computers (IPEC). Piscataway,NJ: IEEE. 2020: pp. 237-241.

[63] Artetxe M, Labaka G, Agirre E. A robust self-learning method for fully unsupervised cross-lingual mappings of word embeddings[J]. [arXiv preprint] [2018]arXiv:1805.06297.

[64] Rasooli, M.S., Farra, N., Radeva, A. et al. Cross-lingual sentiment transfer with limited resources[J]. Machine Translation, 2018, 32: 143–165.

[65] Stephan Gouws and Anders Søgaard. Simple task-specifc bilingual word embeddings. In Proceedings of the 2015 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, pages 1386–1390, 2015.

[66] Goodfellow, I., Pouget-Abadie, J., Mirza, M., Xu, B., Warde-Farley, D., Ozair, S., ... & Bengio, Y. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems - Volume 2. Cambridge, MA, United States: MIT Press, 2014: 2672–2680

[67] Chen, X., Sun, Y., Athiwaratkun, B., Cardie, C., & Weinberger, K. Adversarial deep averaging networks for cross-lingual sentiment classification[J]. Transactions of the Association for Computational Linguistics, 2018, 6: 557-570.

[68] Antony, A., Bhattacharya, A., Goud, J., & Mamidi, R. Leveraging Multilingual Resources for Language Invariant Sentiment Analysis[C]//Proceedings of the 22nd Annual Conference of the European Association for Machine Translation. Lisboa, Portugal: European Association for Machine Translation, 2020: pp. 71-79.

[69] Conneau, A., Lample, G., Ranzato, M. A., Denoyer, L., & Jégou, H. Word translation without parallel data[arXiv preprint]. [2017]. arXiv:1710.04087.

[70] Feng, Y., & Wan, X. Towards a unified end-to-end approach for fully unsupervised cross-lingual sentiment analysis[C]//Proceedings of the 23rd Conference on Computational Natural Language Learning (CoNLL) Hong Kong, China: Association for Computational Linguistics, 2019: pp. 1035-1044.

[71] Wang, W., Feng, S., Gao, W., Wang, D., & Zhang, Y. Personalized microblog sentiment classification via adversarial cross-lingual multi-task learning[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels, Belgium: Association for Computational Linguistics, 2018: pp. 338-348.

[72] Kandula, H., & Min, B. Improving Cross-Lingual Sentiment Analysis via Conditional Language Adversarial Nets[C]//Proceedings of the Third Workshop on Computational Typology and Multilingual NLP. Online: Association for Computational Linguistics, 2021: pp. 32-37.

[73] Ganin, Y., Ustinova, E., Ajakan, H., Germain, P., Larochelle, H., Laviolette, F., ... & Lempitsky, V. Domain-adversarial training of neural networks[J]. The journal of machine learning research, 2016, 17(1): 2096-2030.

[74] Long, M., Cao, Z., Wang, J., & Jordan, M. I. Conditional adversarial domain adaptation[arXiv preprint]. [2017]. arXiv:1705.10667.

[75] Pelicon, A., Pranjic, M., Miljković, D., Škrlj, B., & Pollak, S. (2020). Zero-Shot Learning for Cross-Lingual News Sentiment Classification. Applied Sciences, 2020, 10(17): 5993.

[76] Devlin, J., Chang, M. -W., Lee, K. & Toutanova, K. (2019). BERT: Pre-training of deep bidirectional transformers for language understanding. In Proceedings of the2019 conference of the North American Chapter of the Association for Computational Linguistics: Human language technologies (Volume 1(Long and Short Papers), pp.4171-4186) Association for Computational Linguistics, Minneapolis, Minnesota. URL: https://wwwaclweborg/anthology/N19-1423.

[77] Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., ... & Amodei, D. (2020). Language models are fewshot learners. arXiv preprint arXiv:2005.14165.

[78] Qiu,X.P., Sun, T.X., Xu, Y.G., Shao, Y.F., Dai, N., Huang, X.J.(2022). Pre-trained Models for Natural Language Processing: A Survey. arXiv:2003.08271v2 [cs.CL] 24 Mar 2020. https://arxiv.org/abs/2003.08271v2

[79] Pires, T., Schlinger, E., Garrette, D.: How multilingual is multilingual bert? In: Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics, pp. 4996–5001 (2019). ACL

[80] Lample.G., Conneau. A.(2019). Cross-lingual language model pretraining. arXiv:1901.07291v1 [cs.CL] 22 Jan 2019.NeurIPS

[81] Conneau.A., Khandelwal.K., Goyal.N., Chaudhary.V., Wenzek.G., Guzm´an.F., Grave.E., Ott.M., Zettlemoyer.L., and Stoyanov.V.. 2020. Unsupervised cross-lingual representation learning at scale. CoRR, abs/1911.02116.

[82] Xia, M., Zheng, G., Mukherjee, S., Shokouhi, M., Neubig, G., & Awadallah, A. H. (2021). MetaXL: Meta representation transformation for low-resource cross-lingual learning. arXiv preprint arXiv:2104.07908.

[83] Jacob, D., Ming-Wei, C., Kenton, L., Kristina, T.: Bert: Pre-training of deep bidirectional transformers for language understanding. In: Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics, pp. 4171–4186 (2018). ACL

[84] Hossain, E., Sharif, O., & Hoque, M. M. (2021). NLP-CUET@ LT-EDI-EACL2021: Multilingual Code-Mixed Hope Speech Detection using Cross-lingual Representation Learner. In Proceedings of the First Workshop on Language Technology for Equality, Diversity and Inclusion (pp. 168-174).

[85] Bataa, E., & Wu, J. (2019). An Investigation of Transfer Learning-Based Sentiment Analysis in Japanese. In Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics (pp. 4652-4657). Florence, Italy, July 28 - August 2. https://doi.org/10.18653/v1/P19-1458.

[86] Gupta, A., Rallabandi, S. K., & Black, A. W. (2021). Task-Specific Pre-Training and Cross Lingual Transfer for Sentiment Analysis in Dravidian Code-Switched Languages. In Proceedings of the First Workshop on Speech and Language Technologies for Dravidian Languages (pp. 73-79).

[87] Howard, J., & Ruder, S. (2018). Universal Language Model Fine-tuning for Text Classification. In Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics, 1, 328-339. https://doi.org/10.18653/v1/P18-1031.

[88] Barbieri.F., Camacho-Collados.J., Neves.L., and Espinosa-Anke.L.. 2020. Tweeteval: Unified benchmark and comparative evaluation for tweet classification. arXiv preprint arXiv:2010.12421.

[89] Pikuliak, M., Simko, M., Bieliková, M.(2021). Cross-lingual learning for text processing: A survey. Expert Systems with Applications 165 (2021) 113765

[90] Holger Schwenk and Xian Li.2018. A corpus for multilingual document classification in eight languages. arXiv preprint arXiv:1805.09821

[91] Dong, X. L., & de Melo, G. (2019). A robust self-learning framework for cross-lingual text classification. In Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP) (pp. 6306-6310). Hong Kong, China, November 3–7. https://doi.org/10.18653/v1/D19-1658

[92] Neil Houlsby, Andrei Giurgiu, Stanislaw Jastrzebski, Bruna Morrone, Quentin De Laroussilhe, Andrea Gesmundo, Mona Attariyan, and Sylvain Gelly. Parameter-efficient transfer learning for NLP. In ICML, pages 2790–2799, 2019.

[93] Pfeiffer J, Vulić I, Gurevych I, et al. Mad-x: An adapter-based framework for multi-task cross-lingual transfer[arXiv preprint]. [2020]. arXiv:2005.00052.

[94] Lachraf R, Ayachi Y, Abdelali A, et al. ArbEngVec: Arabic-English cross-lingual word embedding model[C]//Proceedings of the Fourth Arabic Natural Language Processing Workshop. Florence, Italy: Association for Computational Linguistics, 2019: 40-48.

[95] Khalid U, Beg M O, Arshad M U. RUBERT: A Bilingual Roman Urdu BERT Using Cross Lingual Transfer Learning[J]. [2021]. arXiv:2102.11278.

作者简介

徐月梅,北京外国语大学信息科学技术学院副教授。研究方向:情感计算、跨语言情感分析。近年来主持项目多项,包括国家自然科学基金青年项目、北京市社会科学基金项目等。