题目:Mutual Disentanglement Learning for Joint Fine-Grained Sentiment Classification and Controllable Text Generation

作者:费豪,李晨亮,姬东鸿,李霏

单位:武汉大学

会议:SIGIR 2022

工作概括:细粒度情感分类任务与情感生成任务互为对偶任务,两者的输入输出相互倒转,同时两者之间的情感特征可互相补充裨益。本研究基于对偶学习框架,将细粒度情感分类与情感生成任务进行了有机联合,并提出一个互解耦学习机制,以帮助对于情感特征的跨任务借鉴学习。

01

动机介绍 ✦

细粒度情感分类任务(fine-grained sentiment classification, FGSC),其旨在分析给定文本所含针对某项产品或服务等特定方面的情感态度。代表性应用主要包括:基于方面的情感分类(aspect-based sentiment classification, ABSC)和基于方面类别情感分类(aspect-category sentiment classification, ACSC)。

细粒度情感可控文本生成任务(fine-grained sentiment controllable text generation FGSG),其旨在根据给定的细粒度情感状态,生成带有指定的情感的本文。

对于 FGSC,在给定文本输入的情况下,学习背景内容信息是相对更容易,但其往往很难精确地捕获到关键的情绪或观点线索。

对于 FGSG,在给定以情感状态作为输入下,模型可以较为容易地编码出与情感意见相关的特征表示,但其主要挑战在于如何生成丰富的内容,同时将情感特征融合到文本生成中。

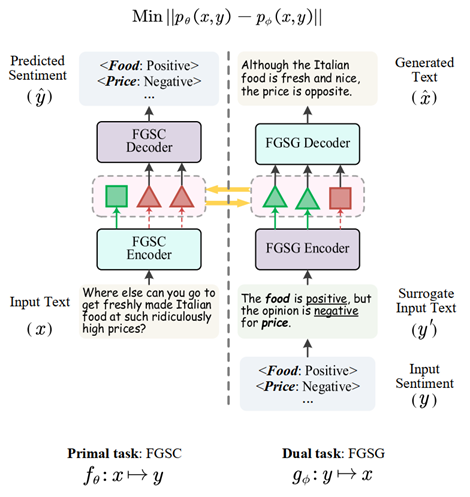

图1:本文研究目标:基于互解耦学习联合细粒度情感分类和情感文本生成建模

基于上述的观察,本文联合 FGSC 和 FGSG提出一个对偶学习系统,如图1所示。

首先,我们对这两个任务的对偶性进行显式建模,鼓励它们相互学习,促进整个联合学习的过程推向互利的方向。

接着,我们借助互解耦学习机制将FGSC任务和FGSG任务的特征表示分解为细粒度的面向方面的意见变量(aspect-oriented opinion variables)和内容变量(content variable)。

最后,我们观察到相比于情感分类任务,文本生成任务更加棘手,因为生成任务的输入是离散的特征(方面类别和情感极性),这使得所生成文本的流畅性、丰富性和正确性难以保证。因此,我们考虑构造代理输入文本(surrogate input text)来代替离散的方面和情感特征输入,将“数据到文本”的方式转换为“文本到文本”的生成方式。

02

对偶学习框架 ✦

主任务模型负责将输入文本x映射到输出的细粒度情感类别y(fine-grained aspect categories& sentiment polarities)。本文主要考虑了基于方面类别情感分类(ACSC),即输出为y={y1,y2,…,yk}, 其中,yk表示第k个方面类别ak所对应的情感极性。

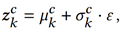

我们直接利用了BERT作为FGSC的编码器学习文本表征H,并基于H通过自注意力机制创建一个显式的内容变量表征zcs 。再生成k个面向方面的意见变量{zck}。具体利用了重参技术,先采样得到k个独立的正态分布先验参数:

再基于此构建出k个隐变量:

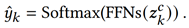

在FGSC的解码端,我们采用多类别分类任务的结构进行情感极性预测:

2.2 对偶任务:FGSG

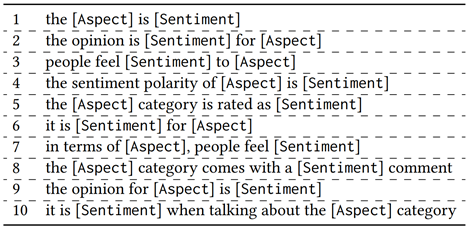

此外,通过定义一些模板,例如“[方面]是[情感]”,“[方面]的意见是[情感]”,我们可以将输入的细粒度情感类别表示成自然语言。如表1所示,我们定义了一些模板用于创建代理自然语言,以重新表述方面类别和情感极性对。

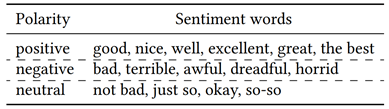

同时,我们还考虑将情感极性词表达丰富化,从而提升语言的多样性。我们主要使用一些同义词来扩大候选词集合。表2列出了本文所使用的若干候选情感词。

表2:候选情感词

当输入有不止一个方面-情感对时,我们将为每个方面-情感对创建一个代理文本。然后我们用连接词连接所有的代理文本。根据两个相邻子句之间是否存在情感转折现象,我们会添加不同的连接词。例如,对于不存在情感转折的情况,使用“and”或逗号,对于存在情感转折的情况,使用否定词“but”或“while”。最后用句点结束完整的文本。

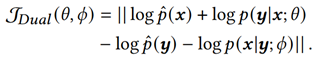

2.3 对偶性建模

首先,两个对偶任务有各自的学习目标:

其目的是优化它们之间的概率对偶,即缩小它们的联合分布之间的差距:

03

互解耦学习机制 ✦

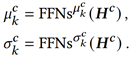

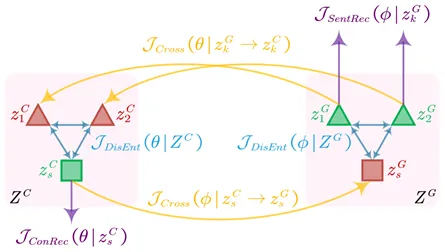

图3:互解耦学习机制示意图,包括1)显式特征重构(紫色)、内部任务变量分解(蓝色)、跨任务表征交叉引用(黄色)。左侧:FGSC;右侧:FGSG

3.1 显式特征重建

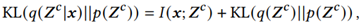

上式中的KL项可以进一步分解为:

其中,第一项𝐼 (𝒙; 𝒁𝑐)代表联合分布的互信息,第二项KL(𝑞(𝒁𝑐)||𝑝(𝒁𝑐))代表变量分解。FGSG过程采用相同的分解方式。

本文利用一个余弦距离函数来度量所有变量的不相似性:

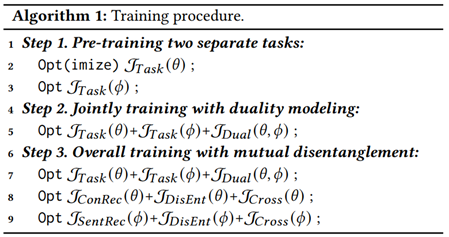

将上述所有学习目标放在一起,我们可以优化整体框架。但是用冷启动的方式同时训练所有部件可能会导致训练不稳定或次优收敛。因此,我们采取热启动训练策略,即首先用任务交叉熵损失分别预训练两个基本任务,一旦它们可以很好地收敛,我们将两个对偶任务联合起来同时训练。当模型的学习稳定下来后,我们将采用上述的对偶学习框架,并进行互解耦学习。下面的算法流程展示了训练策略:

04

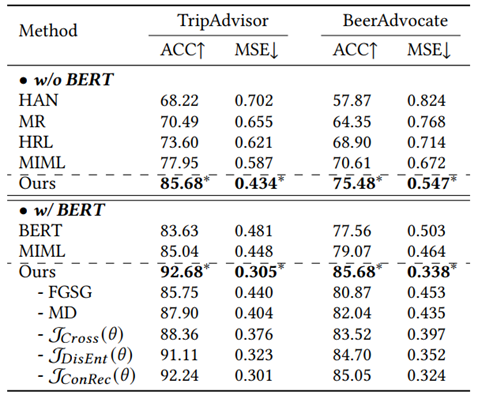

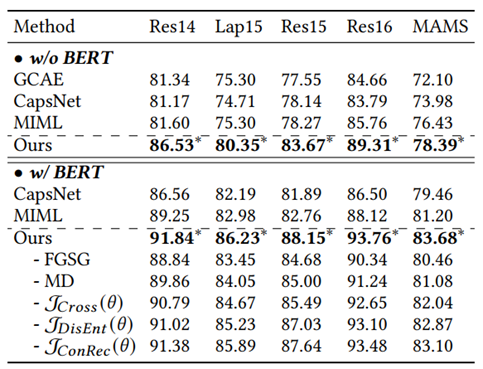

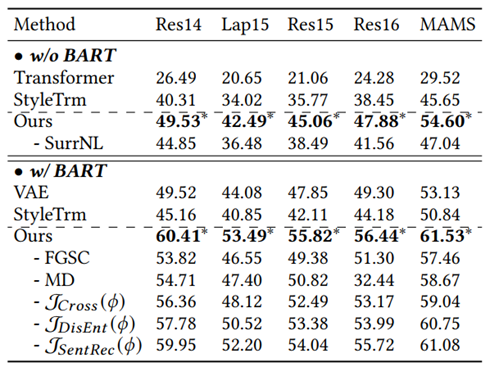

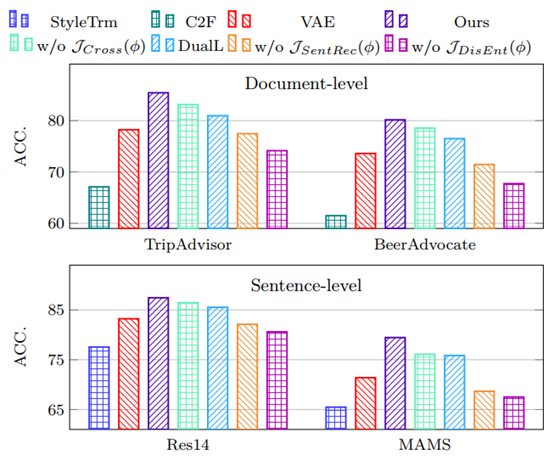

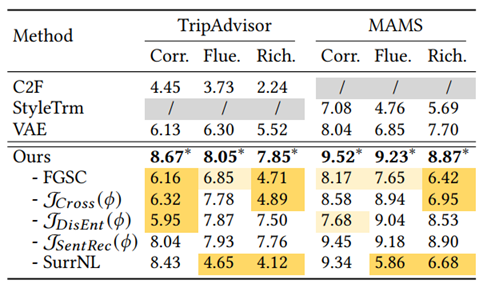

实验结果 ✦

2)在情感分类任务中,对每个细粒度的意见变量进行表征解耦学习亦有必要。

供稿:李晨亮

编辑:宋雪萌

主审:徐睿峰